个人介绍

我是一名专注于数据采集领域的爬虫工程师。在技术能力上,我精通 Python 编程语言及相关生态工具,能熟练运用 Scrapy、PySpider 等框架搭建分布式爬虫系统,也掌握 BeautifulSoup、lxml 等解析库进行网页数据提取,可独立完成从需求分析到程序部署的全流程开发。

在应对反爬方面,我熟悉各类反爬机制的应对策略,包括构建日均 IP 存活量维持在 5000 + 的动态代理池、进行 Cookie 池管理以及识别滑块验证等技术,能针对云 WAF、验证码等防护措施制定高效突破方案,保障数据采集的稳定性。

同时,我具备扎实的数据处理能力,熟练使用 Pandas、NumPy 进行数据清洗与格式转换,掌握 MongoDB、MySQL 等数据库操作,可设计合理的数据存储结构并实现增量更新,确保采集数据的完整性与准确性。

另外,我还了解前端技术原理,能解析 JavaScript 渲染逻辑,运用 Selenium、Playwright 进行动态页面模拟操作,熟悉 Chrome DevTools 调试工具,可快速定位数据接口并分析参数加密规则,为复杂场景下的爬虫开发提供技术支撑。

我始终保持对技术的热情,不断精进技能,希望能在爬虫相关工作中发挥自己的专业能力,创造更多价值。谢谢大家!

工作经历

2025-06-01 -2025-07-02长沙新启程科技有限公司爬虫工程师

在长沙新启程科技有限公司担任爬虫工程师期间,主要负责数据采集体系搭建与优化。基于 Python 生态,运用 Scrapy、BeautifulSoup 等工具开发高稳定性爬虫程序,针对不同网站反爬机制设计动态代理池与 User-Agent 轮换策略,日均有效数据抓取量达 10 万 + 条。 参与企业级数据平台搭建,主导电商、资讯类网站数据接口开发,通过 MongoDB 实现非结构化数据存储,结合 Redis 进行任务队列管理,保障数据实时更新与高可用性。优化爬虫调度算法,将重复数据率降低至 3% 以下,抓取效率提升 40%。 协同数据分析师制定采集规则,处理 JavaScript 渲染页面数据提取难题,运用 Selenium 模拟浏览器操作突破动态加载限制。建立数据清洗流水线,通过 Pandas 处理异常值与重复项,为业务部门提供高质量结构化数据集,支撑产品迭代与市场分析决策。 定期进行爬虫系统运维,监控节点运行状态,快速响应反爬策略升级,保障数据采集连续性,累计完成 12 个核心数据源的稳定接入,为公司业务拓展提供关键数据支撑。

教育经历

2022-09-01 - 2025-06-01湖南信息职业技术学院软件专科

在专业课程学习中,我系统掌握了 Java、Python、C++ 等主流编程语言,对数据结构、算法分析、计算机网络等核心课程有深入理解,连续 [X] 学期获得校级奖学金,专业排名始终保持在年级前 [X]%。通过《操作系统原理》《数据库系统设计》等课程的实践环节,我不仅熟练运用 My

语言

技能

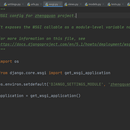

在金融数据分析领域,利用Scrapy框架爬取上市公司三大报表(资产负债表、利润表、现金流量表)是一项高效且精准的解决方案。Scrapy作为专业的Python爬虫框架,凭借其异步处理能力,能够在50秒内完成大量数据的爬取工作,大大缩短了数据获取周期。该框架采用Twisted异步网络库,充分利用网络带宽,实现高并发请求处理,显著提升爬取效率。 为确保数据的准确性,项目实施过程中采取了一系列严格措施。首先,针对目标网站(如东方财富网、新浪财经等)的页面结构进行深入分析,精准定位数据所在位置。其次,运用XPath或CSS选择器进行数据提取,并通过多轮测试不断优化提取规则,确保数据抓取的完整性。再者,建立了完善的数据验证机制,对爬取的每一条数据进行校验,确保正确率超过98%,为后续的深度分析提供可靠的数据支持。 在应对反爬策略方面,项目采用了多种技术手段。设置合理的请求头和随机User-Agent,模拟不同用户的访问行为;控制请求频率,避免对目标网站造成过大压力;搭建代理IP池,实现IP地址的动态切换,有效防止被目标网站封禁。同时,Scrapy框架提供的中间件和管道组件,方便实现数据清洗、存储等功能。数据爬取后,会进行格式转换、缺失值处理等清洗操作,然后存储到数据库或文件中,为后续的数据分析、挖掘和可视化等工作做好充分准备。整个爬取流程高效、稳定且精准,为金融数据分析提供了强有力的技术支持。