全职 · 400/日 · 8700/月信用正常

工作时间: 工作日19:00-24:00、周末08:00-19:30工作地点:

远程

服务企业:

0家累计提交:

0工时

聊一聊

个人介绍

熟悉各类大数据产品,spark,flink,现任大数据开发工程师,熟练运用多种开发语言java,scala,python,工作较为清闲,寻找各种可以兼职的岗位。熟悉SparkStreaming、KafkaStreams等流式计算。熟练使用Flume、Kafka、Oozie、Sqoop等大数据组件。 熟练使用MySQL,了解Oracle等关系型数据库。熟练使用HBase、MongoDB,了解Redis、Cassandra等NoSQL数据库。

工作经历

2021-10-01 -至今滴普科技大数据开发工程师

公司主要做大数据产品,有dlink、datafacts、dct等,我主要负责做客户交付开发,使用公司产品或者定制化开发。

2019-02-01 -2021-09-30中软国际大数据开发工程师

负责公司内部离线程序到实时程序的转换,按要求达到实时性。编写sparkstreaming和flink实时程序,以及开发功能性python脚本。

教育经历

2014-07-01 - 2018-07-01长治学院信息与计算科学统招本科

在学校成绩优秀,获得奖学金,参加过国家的数学建模等。

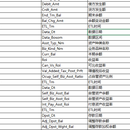

技能

作品

根据客户需求在dataphin上dwd、dws、ads层开发、数据验证、代码优化等 使用阿里dataworks数据库 根据不同模型算法,实现逻辑开发,包括拉链、增量、修改等

2023-05-23 11:22

1.主要负责实时程序中 p 层受理指标、dma 层人力指标编写。 2.主要负责对受理相关的保费、fyc、件数、撤件件数、撤件费用和承保 fyc 离线 sql 改造。 3.负责数据初始化脚本,数据备份脚本,离线程序调度脚本等。

2023-05-23 11:16